この???な部分は、サンプリング原理でよく知られている、サンプリング周波数の1/2よりも高い周波数をサンプリングした際に発生する、エイリアス信号が発生してしまい、さらにカメラ固有のパターンノイズが重畳したものです。

サンプリングできない密度の、つまりサンプリング周波数の1/2よりも高い周波数のデータがある場合に、元には存在していない信号であるエイリアス信号が現れてしまいます。これは、変調と同じ原理なので、この写真でわかるように、目立つ場所と目立たない場所が出てきます。

この写真の場合は、手すりの密度が、LEICA-Digital-Module-RのイメージセンサのCCD配列で2列の密度を下回る密度になり、都合悪くなったところで、RGBのデータにエイリアス信号が綺麗に発生してしまい、絵がめちゃくちゃになったです。この場合は、ベイヤー配列のように、1つのピクセルが位置の違う複数のサブピクセルで構成されているものを、補完処理で取り扱ってしまうため、エイリアス信号が色の強い変動として見えやすく、この例のようになります。

余談ですが、カメラの世界では、このような状況を、モアレとか、色モアレ…なんて名づけているみたいですね。用語が、他の世界と違うのも、カメラの世界の歴史のなせる業ですね。

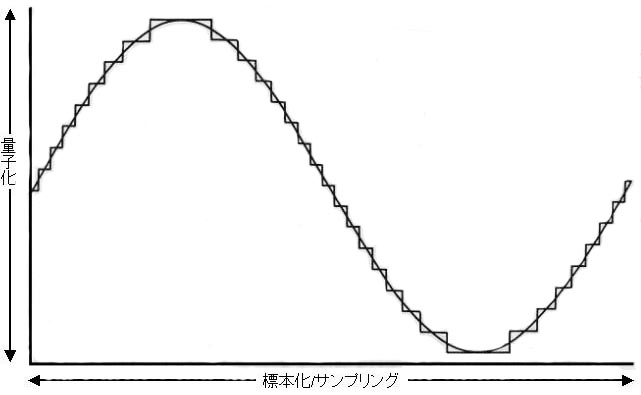

エイリアス信号とは、以下のようなもので、異なる周波数で近接しているために、現れる全く別な周波数の信号のことです。

|

| 一段目のサンプリング周波数の1/2よりも高い信号を、二段目のサンプリング周波数でサンプリングしてしまうと、三段目のような波形の位相差、四段目のような信号が生まれてしまいます。これが、エイリアス信号です。 |

この問題を解決する方法も、はじめから理論的にわかっています。

サンプリング周波数の1/2よりも高い周波数のデータをカットすればよい…ということです。

このことは、直感的にも理解できる説明があります。

レンズの解像度は、MTFチャートで示されています。

MTFチャートは、一定の範囲で、何本の線が判別できるかによって、測定します。

|

MTF 絞り1.4

|

MTF 絞り2.8

|

MTF 絞り5.6

|

|

|

|

|

|

受光素子がMTFチャートを描ける限界は、どれだけか…1サブピクセル単位では、色が得られないことはお分かり戴けると思います。では白と黒の線はピクセル単位の幅か…違いますよね。1本の線を正しく判断できるためには、ピクセル単位で白と黒があると、ずれてしまうと、白になったり、黒になったりします。この答えは、ピクセルの幅の倍の線が最小である…ということです。そうであれば、演算して、元の状態に出る…というのが、サンプリング周波数の1/2の周波数が再現可能な元のデータであるということです。

イメージセンサでいえば、周波数とはセンサの配列そのものと同じような意味となります。まじめに議論するとするとわかりにくいので、ここでは便宜的にイメージセンサ数で述べてしまいましょう。1000万画素のイメージセンサであれば、それはサブピクセル数ですので、理論的には250万画素ですが、その半分、つまり125万画素の解像度を超える絵はないようにするということです。つまり、それ以上の解像度にならないように、光を「散らして」やればよいわけです。

|

|

光学ローパスフィルタ

|

この役割を負っているのが、ローパスフィルタです。

光学的ローパスフィルタは、あるドットに届く光を他のドットにも分散させるという動作をします。

すでにご説明したように、赤や青のサブピクセルは1サブピクセルおきにしか配置されていないので、1ピクセル先に、つまり2サブピクセル先に(場合によってはもっと遠くに)、ローパスフィルタは光を飛ばしてしまうわけです。ですから、いろいろなメーカーの資料が、「ローパスフィルタは画質に影響する」と説明しているのが、いかに控えめな話題であるかをご理解いただけると思います。

そもそも、理論どおりに考えて、そのまま作ると、ローパスフィルタの性能の解像度のカメラしか作れないわけで、1000万画素の機種が正しく表現できるのは理屈で考えると、125万画素相当に過ぎない…という話題になります。

本コンテンツの冒頭で、「1000万画素機の絵しか受け付けない」という雑誌社の話題を、笑いながら話題にしている背景がお解りいただけると思います。

このような背景があるため、LEICAではローパスフィルタが意図的にないような作り方にして、利用者にその使い方を預けたわけです。ローパスフィルタと同等な処理は、コンピュータ上でも可能ですので、現像処理を行う中で、困ったら実現すればよい…という考え方です。これで、LEICA自身がそうした現像ソフトを出していればたいしたものですが、実際には他社任せなので、困るのですが…(^^;

先に示したサンプルと、LEICA-Digital-Module-Rとの比較を示します。

ローパスフィルタがない理由のプラスの側面をお分かりいただけるとかと思います。

実際のカメラでは、補完処理をしたデータを含めた状態でエイリアス信号が目立たなければ良い様に考えられているので、ローパスフィルタと補完処理などを組み合わせて設計しているのではないでしょうか。

ただ、補完処理は、付け焼な「技術」に過ぎないものであり、それ以上のものではありません。取得されていない情報を、「空想」で加えているだけであり、それ以上のものではありません。ですから、絵のつじつまを合わせているに過ぎず、別に、高い解像度で絵を実現しているものではありません。

カラーセンサーが1素子ですべての色を取得できないために、いろいろな問題が発生します。

特に、色の再現の問題は、やっかいです。

なにしろ、RGBの色を取得している場所が違うために、グラデーションのある絵などを撮影すると、ローパスフィルタがゆるい場合は、センサごとの光のエネルギー量に位置による違いが発生してしまいます。センサの場所により、色が違うのですから、異なる色に再現されてしまいます。いわゆる、偽色です。

偽色は、ベイヤー配列のようなサブピクセルごとに位置が違うカラーセンサー方式をとる限り、原理的に避けがたい問題です。

偽色の対策も、光学的に行うならば、エイリアシング信号と同じで、ローパスフィルタになります。ローパスフィルタは、もともと1素子で受けるべき光を複数の素子に散らすわけですから、偽色は発生しにくくなります。

もっとも、絵を「ぼかす」わけです。あまり強くローパスフィルタをかけると、絵が鈍くなってしまいますので、バランスが必要でしょう。ですから、もしもローパスフィルタを弱くしたりして、偽色が発生したら、現像のパラメータを変更して、偽色補正処理を行い、我慢できる範囲まで、見ながら合わせていくという方法になります。これのような後での処理で対策する場合は、撮影時にはとてもできない指定ですので、rawデータ撮影でないと実現できません。

LEICA-Digital-Module-Rは、このような考え方で、光学的ローパスフィルタになにも期待しないようになっています。

雑誌を見ていると、「偽色が見られる」とか、「解像度が高い」とか「解像度が低い」なんて、平気で書いています。Jpegで圧縮した絵で評価して解像度もないですが、それ以前に、原理を踏まえて書いているのでしょうか。

カメラメーカーからすると、解像度を優先するとローパスフィルターもゆるくするわけで、そうすれば偽色が発生もしやすくなるわけです。LEICAみたいに利用者に選択を預けたいのがメーカーの本心でしょうか、そういうわけにも行かず、中途半端な場所を見つけるためにだけ、汲々としているのではないかと、なんか同情したくなる気もします。

でも、メーカーのそういう対応が原因で、日本のカメラマンは調子に乗って「Jpegで十分」なんて、ちんぷんかんぷんな主張をする人たちも出るのでしょう。欧米のカメラマンと、かなり違うみたいな気がします。

| ■ ちょっとかわいそうな、foveon(フォベオン) |

なぜイメージセンサーは、サブピクセルでRGBの単色を受けるようになっているでしょうか…

その理由は、CCDやCMOSの受光センサーの動作原理にあります。

|

CCDやCMOSの受光センサーの原理

|

|

| 光子がエネルギーバンドから電子を「打ち出す」原理のイメージです。InGaAsP内で電場がかけられていることにより「エルルギーバンド」が形成され、そこの自由電子が光子によりにより「打ち出される」ことで、電子が得られます。これにより測定が可能になります。 |

今使われているセンサーは、半導体結晶でのエルネギーバンド中に束縛されている電子から光子により電子を「打ち出す」方式であるため、1つの光子あたり1つの電子しか得られません。

光子ひとつあたり電子ひとつですので、情報量が少ないため、とても色を光子から判断することはできません。

こうした背景があり、光子を光学的フィルターを使用して、RGBに分類して、それぞれを測定するということが考えられたわけです。

今、超伝導光センサーの研究が進められています。超伝導光センサーは、超伝導状態による相転移を利用するものですが、その方式ですと光子ひとつあたりで数千という相転移が発生するので、遥かに効率が良いので、光子のエネルギー量の測定が可能になります。つまり、ひとつのセンサーですべての色を判断することが可能となります。そうしたセンサーでは理想的なものを実現できそうです。

とはいえ、そんなセンサーがすぐにできるわけもなく…まして、民生用カメラに使われる日なんて、あるのかないのかも不明です(今でも特殊用途であれば実用化されています)。しかし、ひとつの素子で、すべての色を決めることができれば、それは理想的なサンプリングということになります。

で、現行の技術でそれを実現しようというアイディア素子の技術が登場しています。それは、アメリカのx3 techology社が開発しているfoveonセンサーです。

光子が半導体内で電子を「打ち出す」場所は、光の波長により表面からの深さに違いがあります。波長が長いほど、深い場所になるのです。foveonはそれを利用して、打ち出される位置に対応して電子を得ることにより、1つのサブピクセルの位置で、波長の短い順に、bgrの三種類の光に対応した電子を集めることができます。

|

|

SIGMA SD-14

画面解像度2652*1763

|

|

|

Nikon D40

画面解像度3008*2000…(^^;

情報量で見ると理論的画素数ではSD-14の1/3しかありません

世の中、これで同一の仕様みたいな説明なんて、

やっぱり、おかしいんじゃないですかね…(^^;

|

この方式にすれば、得られるRGBのデータは同じ位置から情報を取得するので、位相のずれによる問題は発生しなくなります。ですから、偽色は、原理的に存在しません。

また、画素そのものは、サンプリング原理に従った画素として取り扱えます。

ですから、最近に発表されたFOVEON FX17-78-F13 Image Sensor(SIGMA SD-14に採用されています)は、2652*1763=4675476の有効画素数を持っています。

foveonは、各色のサブピクセル数と、ピクセル数が同じになりますので、これをベイヤー配列のセンサーを使用したカメラと比較すると、1870万画素に相当します。

ただ、ちょっとお待ちください…foveonを使用したカメラの画面解像度は、2652*1763です…それって、理論的には全くそうなのですが、他のカメラは、「なんちゃってサンプリング原理」に基づいているため、まじめに処理していません…(^^;…ですから、Nikonの630万画素機の画面解像度である3008×2000を下回っちまうのです…(^^;…理論的画素数ではsd-14がd40の3倍はありますし、それだけで見れば、Nikonの最上位機種を超えているのに…(^^;

そんな背景から、SIGMA sd-14本体とその現像ソフトには、縦横2倍に拡大して現像する機能が備わっています…(^^;…仕方ないというか、破れかぶれというか…

真面目に作ったら、数字が…かわいそうなfoveon

foveonは、実際の解像度ではなく、1つの画素を3画素として数えて宣伝しています…サブピクセルを宣伝にしているのに対抗してのことみたいです…業界からは、おかしいとまで言われているみたいで…どこまでもかわいそうなのでした…(^^;

余談ですが、foveonは解像度が低いにもかかわらず、絵の解像度が高いという評判です。

当たり前ですよね、だって、原理どおりであり、情報量があるんですもの…ひとつひとつの情報のレベルは低いとしても…。この当たり前の事を忘れて技術開発されているのが、デジタルカメラの面白いところです。

| ■ 静止画しか撮れないですけど…マルチショット方式 |

ここでご説明している話題は、実は、なにも新奇な話題ではありません。それどころか、至極順当な話題です。別に、今に始まった話題ではなく、初めてデジタルカメラが作られたときから、知られていたものです。

すでにご説明したように、現代の技術では、1素子ですべての色を検知することが極めて難しいため、解決策は2つしかないのでした。

ひとつは、ベイヤー配列のような、位置をずらして色情報を得るタイプ、今のデジタルカメラの主流技術です。この方法は、1回のシャッターで絵が撮れるので、現代の主流になるのは当然です。光学受光素子は、光を正しく受けるために、シャッターが必要です。

もしも、1回のシャッターで、同時にRGBのデータを得る方法は、光を光学的に3つに別けて受光する3CCDもありますが、この方法はCCDの特性が違いますし、光も1/3に弱めてデータを得ます…それに加えて光学的経路が長くなるので、今まで開発されているレンズはほとんど使えず(いわゆるレトロフォーカスレンズしか無理ですね)、やっぱりカメラの絵には無理です。

で、シャッター1回で撮影するのを諦めて、何回かシャッターを切れば、別な方法があります。

マルチショットと呼ばれる撮影方法です。

RGBに応じてシャッターを切ればいいんですよね、割り切って…。

この場合は、カラーフィルターを取り替えながら撮影する方法と、カラーフィルターをもったCCDなどの受光素子をサブピクセルセイズでずらして撮影する方法があります。以前は、前者が主流でしたが、今は後者が主流です。なぜならば、必要に応じて1回のシャッターで撮影することも、マルチショットで撮影することも可能になるからです。マルチショットのシャッターは、3〜4回切るのが多いですが、ずらすタイプの場合は1/2サブピクセル分だけシフトして16回切って撮影する方法もあります。

このような、マルチショットタイプのカメラは、プロが愛用している35mmよりも大きなサイズのものが、ほとんどです。例えば、hasselbladなんかです。本体とデジタルバッグで数百万円もします…製造量、少ないですから…。

|

|

|

Hasselblad H2 camera + CF39 MS(Multi-shot) Degial Back

|

この方法で撮影した場合は、被写体の状況の変動…照明とか被写体の移動が問題なだけで、ベイヤー配列の問題点である空間周波数が本来的に持つ位相差と、なんちゃってサブピクセルがないので、偽色はほとんどなくなります。

問題点があるとしたら、撮影している間に被写体が動くと困ることくらいでしょうか…。

映像を映し出すシステムでは、プロジェクターに採用されているdlpという技術が、このように、3色の色を順番に表示する方法を取りますが、撮影時にやると、さすがに難しいですね。

私は、このような凄いカメラを持っていないので、人から聞いた話ですが、このカメラで撮影した絵は、次元が違うそうです…。

これまで説明してきた話題をまとめると、デジタルカメラの絵を支えている、画素/ピクセルとは、実は同じ仕様ではなく、原理や方式により、質の違いがある、ということです。

まじめに現像したfoveonやhasselbladの1画素には、得られた光の「本当の情報」が使われていますが、大部分のデジタルカメラは、補完処理をした「なんちゃって情報」を赤と青の情報では75%使用しています。

ところが、今書かれているカタログには、堂々と「○○○○万ピクセル」とか書かれちゃっているのです…本当は、「○○○○万サブピクセル」と書くべきなのに…。

これって、なんか不自然…と思うのは私だけでしょうか…(^^?

ところで、ここれまで述べてきた話題は、大切なピクセルとは何かという点で、「本当の情報」と「なんちゃって情報」という視点で説明してきました。実は、これだけで説明するのは、まだ足りない話題があります。

それは、画素/ピクセルの情報は、どれだけの精度で正しく読み出されているのか…という視点も必要だからです。

CCDやCMOSから得られるイメージデータは、rawデータとして得られます。

まあ、本当に生のデータのままではないのですが、この得られるデータは、すでに説明したように、アナログデータをデジタル化したものです。アナログ/デジタル変換は、ADコンバーターにより行います。

ADコンバーターの評価には、いくつか指標がありますが、一番使われるのは、ビット数です。

NikonやCanonは、12bit、4096です。これは、アナログ出力を4096等分に分割して数値化しているということです。

|

|

PENTAX K10D

別になにか気に入らないわけではないですが、

宣伝のための仕様は意味がないですよね…

22bit ADとまでなるとね…おふざけとしか思えない…(^^;

|

OLYMPUSやLEICAは、16ビット、65536です。これは、アナログ出力を65536等分に分割して数値化しています。より、精細という意味になります。

pentax k10では、なんと22ビット、4194304です。

でも、ちょっと待ってください…イメージセンサの出力って、どれだけあるのでしょうか…(^^;

pentax k10がどのようなセンサーを使用しているか知りませんが、先に例でご説明したKodak kaf-10010ceのサチレーション信号レベルは、40万electoron、電子40万個に過ぎません。

これを基準とすると、12bitで電子97個分刻み、16bitで電子6個分刻み、22bitで0.09個分…(^^;

実は、結構前ですがOLYMPUSの人と話していて、16bitのAD変換ってどれっくらいの精度で実現しているんですかと質問して、凍りつかれたことがあります…(^^;

だいたい、現代物理学を知っている人の常識で、自然界には「アナログ」という物理量が存在しないというものがあります。光の最小単位は光子ですし、電気の最小単位は電子ですから。

その最小単位よりも小さい物理量を取り扱うということは、その精度が必要であるということです。いったいいつ、pentaxは0.09個分の電子の計測する技術を開発できたのでしょうか…(^^;

アナログアンプで電子ひとつを正しく取り扱い、それを計測することだって、信じられない話題です。だって、そんなに安定した、ノイズのない世界が、簡単に作れるわけがありません。

つまり、22bitといっても、そうしたADコンバーターを使用しているだけで、有効桁数はどれだけなのかわからない…ということです。12bitあるのか、16bitあるのか。有効桁数もわからないデータなんて、宣伝のために人を惑わす目的以外に、なんの意味があるんだろう…(^^;

16bitですら精度はどれくらいかなーと思いますが、22bitだと、ウソですよね、受光素子と組み合わせて意味ある、そんな精度のもの作れるわけがありません、現代の技術で…。

実は、オーディオの世界でも、売りたい一心で、こうした無意味な技術製品が多く作られた時代があります。

一生懸命、真面目に、でも、売りたい一心で、ついやっちゃう…それが、お笑い技術論の本質です。

ここで説明した話題について、根本的なご説明が必要でしょう。

なぜ、今のデジタルカメラの技術は、そこまで批判される必要があるのか…

そのお答えは、簡単です。

存在しない情報は、どのような技術でも生み出せないからです。

出来もしないことを、ごまかしてまで宣伝文句にしてしまい、技術的な意味を伝えることができなくなってしまっている実態、看過し難いものです。笑いを取るのが業界全体からの目的なら、成功しつつあるとは思いますが…。なんか、将来に新技術が開発されて、ここで説明した問題が克服されたら、「フルスペック・メガピクセル」とか言い出しそうですよね。ハイビジョンテレビが、ありもしないフルスペック放送を表示できると、「フルスペック・ハイビジョン」と宣伝しているようなものですが…(^^;

オーディオにも、お笑い技術として、失われた記録されていないオーディオ信号を甦らせるというものがあります。なんのことはない、高域に雑音を混入する技術であり、まともなオーディオ技術ではありません。

デジタルカメラの画素の話題も、同じです。

補完技術で画面を構成する限り、その技術は、本質的な技術では、あり得ません。

どんなに研究を重ねていても、このような形で宣伝していては、売りたい一心故の「なんちゃって技術」であることに、違いはありません。

別に、研究者の本心ではないでしょう。

より進んだ技術が、いつか、本物の技術に立ち返る日をもたらすのではないかなーと、時々思います。